شرکت انویدیا به تازگی از فناوری پیشرفتهای با نام Helix Parallelism رونمایی کرده است که نخستین راهکار عملیاتی برای پشتیبانی از کانتکستهای بسیار طولانی در مدلهای هوش مصنوعی محسوب میشود.

به گزارش تکناک، این فناوری به گونهای طراحی شده است که میتواند تا ۳۲ برابر بیشتر از روشهای پیشین به کاربران همزمان سرویس بدهد، بدون اینکه زمان پاسخگویی افزایش یابد یا کارایی افت کند.

مدلهای زبانی بزرگ، مانند چتباتها یا دستیارهای هوشمند، برای تولید هر پاسخ، نیاز دارند به حجم عظیمی از دادههای قبلی مراجعه کنند، که با آن مکالمه صورت گرفته است. این دادهها در حافظهای به نام KV cache ذخیره میشوند و هر بار که مدل میخواهد کلمهای تولید کند، باید این حافظه را اسکن نماید.

این فرایند نهتنها پهنای باند حافظه کارت گرافیک را تحت فشار میگذارد، بلکه بهدلیل بارگذاری مکرر وزنهای شبکههای FFN (شبکههای تغذیه پیشرو)، باعث کندی پاسخگویی در سناریوهای بلادرنگ میشود. تا پیش از این، توسعهدهندگان از تکنیکی به نام Tensor Parallelism استفاده میکردند تا این بار پردازشی را میان چند GPU تقسیم کنند. اما این روش با بزرگ شدن مدل، دیگر پاسخگو نیست و باعث تکرار دادهها و مصرف بیشتر حافظه میشود.

فناوری Helix انویدیا با استفاده از دو نوآوری کلیدی، کارایی مدلهای هوش مصنوعی را به سطح جدیدی رسانده است:

- موازیسازی توجه با KV Parallelism: در مرحله Attention، فناوری Helix از روشی به نام KV Parallelism استفاده میکند، که دادههای حافظه را بدون تکرار میان چند GPU تقسیم میکند. هر GPU تنها بخشی از دادهها را مورد پردازش قرار میدهد و این تقسیم کار باعث کاهش فشار حافظه و افزایش سرعت میشود.

- ادغام هوشمند با Tensor Parallelism: پس از انجام مرحله Attention، واحد پردازش گرافیکی (GPUها) وارد حالت Tensor Parallelism میشوند تا لایه FFN را پردازش کنند. این ساختار ترکیبی باعث استفاده حداکثری از منابع GPU و کاهش زمان بیکاری میشود.

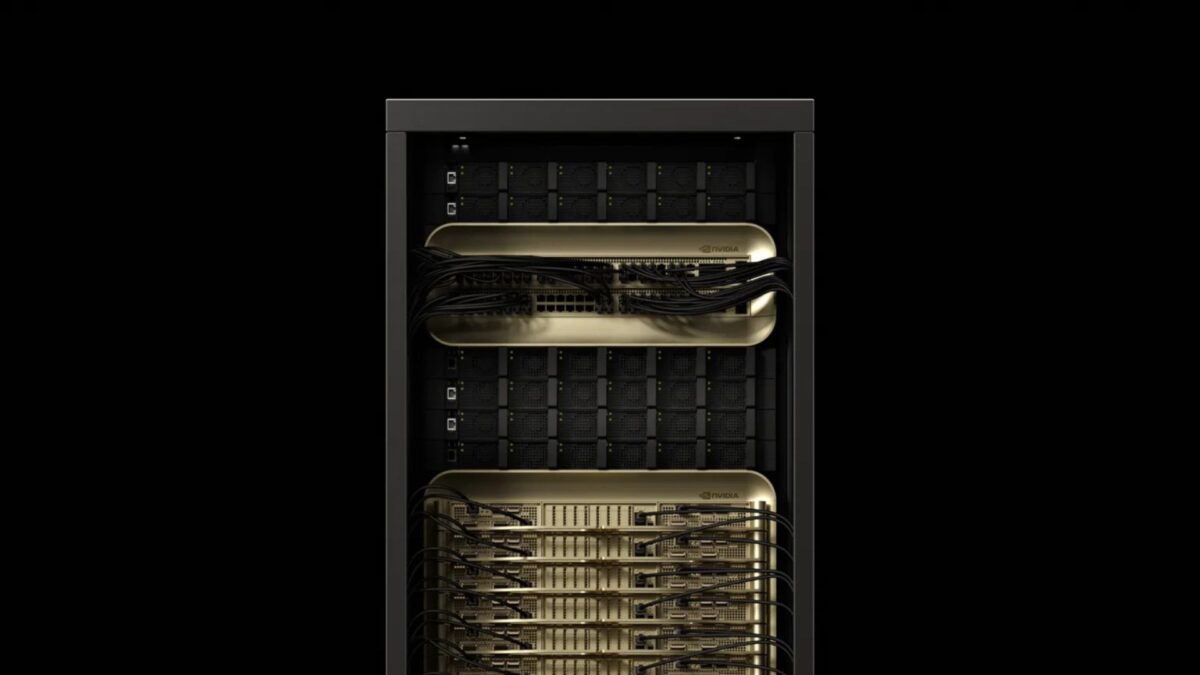

فناوری Helix انویدیا به طور خاص برای معماری جدید Blackwell طراحی شده است؛ پلتفرم GPU پیشرفتهای که با پهنای باند فوقالعاده بالا و توان محاسباتی FP4، زیرساخت مناسب را برای مدلهای عظیم هوش مصنوعی فراهم میکند.

همچنین Helix با بهرهگیری از ارتباطدهندههای فوق سریع NVLink و NVL72، انتقال داده میان GPUها را با حداقل تأخیر انجام میدهد. علاوه بر این، با استفاده از تکنیکی به نام HOP-B، همزمانی انتقال داده و انجام محاسبات ممکن شده است تا زمان پاسخدهی کاهش یابد.

بر اساس آزمایشهای انجامشده روی مدل غولپیکر DeepSeek-R1 با ۶۷۱ میلیارد پارامتر و کانتکست یک میلیون توکنی، فناوری Helix توانست تا ۳۲ برابر بیشتر از روشهای رایج، همزمان به کاربران خدمات ارائه دهد، آن هم بدون اینکه تأخیر افزایش یابد.

در سناریوهای با بار کم، زمان بین تولید هر توکن نیز تا ۱.۵ برابر سریعتر شده است. بهمنظور جلوگیری از جهش ناگهانی مصرف حافظه، فناوری Helix انویدیا از رویکرد بهروزرسانی چرخشی KV cache استفاده میکند، که توزیع بار را در GPUها متعادل نگه میدارد.

فناوری Helix اکنون این امکان را فراهم کرده است که مدلهای هوش مصنوعی نهتنها از نظر حجم دادهها بلکه از نظر سرعت و مقیاس پاسخگویی نیز گسترش یابند. از دستیارهای مجازی و رباتهای مشاور حقوقی گرفته تا ابزارهای پیشرفته همکاری، همگی میتوانند با بهرهگیری از Helix به حجم عظیمی از اطلاعات دسترسی داشته باشند و در عین حال، پاسخگویی سریع و بلادرنگ خود را حفظ کنند.

بدون شک، این دستاورد انویدیا نقطه عطفی در توسعه نسل جدید هوش مصنوعی مقیاسپذیر به حساب میآید.